KI kann viel. Doch belastbar sind die Resultate maschinellen Lernens und zielführend ist das maschinell instruierte Handeln nur dort, wo die Menge der zu analysierenden Daten endlich ist.

Jeder weiß, dass zwischen dem, was ist und dem, von dem die meisten Menschen glauben es sei, ein tiefer Graben klaffen kann. Umfragen, gleichgütig zu welchem Gegenstand, „wissen“ das auch. Gleichwohl werden heute nach wie vor wichtige Managemententscheidungen, etwa darüber, in welche Markt-, Technologie- oder Zielgruppensegmente präferiert investiert werden soll, zu einem nicht geringen Teil von den Ergebnissen von Marktbefragungen abhängig gemacht.

Die Belastbarkeit der auf solchen Umfrageergebnissen beruhenden Gründe, Gründe, warum Entscheider glauben, es sei sinnvoll „hier“ und nicht etwa „dort“ zu investieren, ist ähnlich zweifelhaft wie die Belastbarkeit von Gründen, die auf historischen Erfolgsperioden basieren, wenn also zum Beispiel zurückliegende Umsätze einer Periode x Vertriebsmanager in einer laufenden Periode y dazu bewegen, über ein aus beiden Perioden abgeleitetes Vertriebsbudget der kommenden Periode z zu entscheiden.

Im ersten Beispiel sucht der Entscheider in Ermangelung von Wissen im Wege einer repräsentativen Umfrage Zuflucht bei dem vermeintlichen Wissen einer befragten Stichprobe („vermeintlich“ deshalb, weil sie ja nur etwas Belastbares zu ihren heute überwiegenden Wünschen und Begehrlichkeiten sagen kann); im anderen Fall sucht er die Entscheidung in der vermeintlichen Objektivität von Zahlen, die aus einer zurückliegenden Unternehmensperiode stammen und mit der künftigen Periode rein gar nichts zu tun haben müssen. Die unternehmensinternen spezifischen Bedingungen des künftig stattfindenden aber heute geplanten unternehmerischen Handelns und die externen Marktbedingungen können sich bis zum Zeitpunkt dieses Handelns signifikant verändert haben.

Bizarr wird es, wenn Marktbefragungen mit dem Ziel, Unternehmensentscheidungen für die Märkte von morgen zu treffen, nicht mehr nur darauf abstellen herauszubekommen, was eine Zielgruppe heute angibt heute zu tun, zu lassen oder zu wollen, sondern darauf, was sie glaubt morgen zu tun, zu lassen oder zu wollen, oder noch besser, was ihrer Meinung nach morgen der Fall sein wird, wenn also in Wahrheit das Entscheider-Kalkül, in wen oder was er oder sie investieren soll, an eine befragte Stichprobe delegiert wird.

Dies lässt sich nicht mit dem Argument, es gebe halt keine belastbareren Entscheidungsgründe, legitimieren. Multipliziert man nämlich die Vergleichsdaten, die die Entscheidungsgrundlage darstellen sollen, vermeintlich umsichtig mit einem Wahrscheinlichkeitsfaktor, hat man deswegen keineswegs zuverlässigere Daten gewonnen. Die Attribution einer Wahrscheinlichkeit ist ihrerseits willkürlich. Sie kann die Rahmenbedingungen, aus denen eine zukünftige Marktrealität gebildet wird, nicht antizipieren. Auch ceteris paribus-Unterstellungen sind willkürlich und können gar nicht empirisch gedeckt sein, da die Vergangenheit logischerweise nicht einmal ein Indiz für die Beschaffenheit der Zukunft liefern kann.

Gleichwohl werden „errechnete“ Wahrscheinlichkeiten regelmäßig darauf verwandt, Entscheider zu dispensieren, nachdem sich die empirische Realität dann eben doch weit von der von ihnen vorhergesagten unterscheidet oder prognostizierte Erfolge weit jenseits der tatsächlich erreichten liegen. Stets können sie sagen: „Ich habe ja nicht behauptet, dass es so kommen wird; ich habe nur gesagt, es gebe gute Gründe, dass es so kommen kann.“ Gut sind solche Gründe aber eben leider gerade nicht.

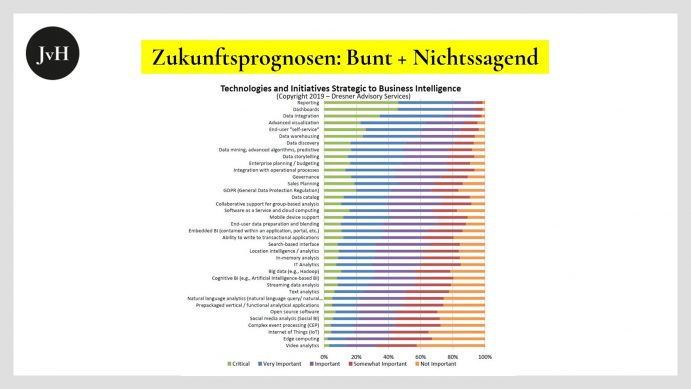

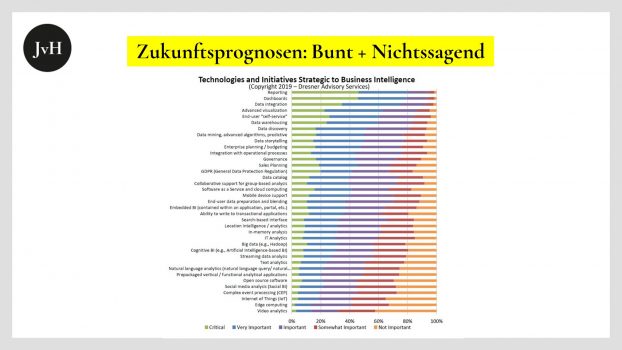

Die Absurdität der Evidenzzuschreibung solcher Marktbefragungen macht nicht an den Grenzen der B2C-Märkte halt. Auch im B2B-Umfeld trifft man laufend auf bunte Grafiken wie die oben abgebildete, die uns erzählen, wieviel Prozent einer Business-Zielgruppe a erwartet, morgen werde eine Technologie x ein Marktsegment z dominieren… Wenn man dann, sagen wir, zehn User- bzw. Berufsgruppen, zehn Marktsegmente und zehn Technologien in das Befragungsrennen wirft, erhält man wunderbar feingliedrige und herrlich bunte Grafiken, die nur ein Manko haben: Sie sagen rein gar nichts auch nur rudimentär Belastbares über die Zukunft voraus. Zu den bereits benannten Willkürlichkeiten tritt hier außerdem der weitere Missstand hinzu, dass User in aller Regel hinsichtlich der von ihnen taxierten Technologien Amateure sind, Anwender, wie jeder x-beliebige Konsument auch.

Das Phantasma der Objektivität entfaltet eine erstaunliche rhetorische Potenz: Weil erstens die Zahlen aus repräsentativen Marktbefragungen oder historischen Periodenerfolgen tatsächlich selbst, als Zahlen, nicht bezweifelt werden können und für sich, als Zahlen oder Grafiken, einfach wunderbar objektiv aussehen und weil zweitens auch ihr jeweiliges Referenzobjekt, in Fall unserer beiden Beispiele also die befragte Stichprobe oder die Vergleichsperiode, unzweifelhaft existent sind und weil drittens auch die Zulässigkeit der Zuordnung der Zahlen zu den Referenzobjekten absolut legitim ist, werden Manager dazu verführt, viertens mit allerruhigstem Gewissen den Trugschluss zu vollziehen, die Übertragung der gewonnenen Erkenntnisse auf Märkte, die es noch gar nicht gibt oder auf Perioden, die noch gar nicht begonnen haben, sei ebenso zulässig und objektiv „richtig“, wie die Zahlen und zugehörigen Referenzsachverhalte, die als „Grund“ herhalten müssen, selbst.

Welcher prognostische Wert in empirischen Umfrage- oder historischen Erfolgsdaten steckt erkennt man nicht nur im politischen Raum an den regelmäßig eklatant „daneben“ liegenden Prognosen der Wirtschaftsinstitute und Wirtschaftsweisen oder an den überwiegenden Fehlprognosen gefeierter Börsenanalysten, sondern auch an den bisweilen um ein ganzes Jahrzehnt daneben liegenden Prognosen zu Technologie-Trends wie denen des amerikanischen Instituts Gartner mit seinem Hype Cycle. Dass derlei Prognosen regelmäßig (um nicht zu sagen fast immer) vollkommen daneben liegen, ändert nichts daran, dass sich alle Welt an ihnen orientiert. Das Streben nach Sicherheit sticht das Streben nach Wahrheit offensichtlich immer aus.

Vor dem Hintergrund der skizzierten Fehlbarkeit humaner Prognosen stellt sich die Frage, ob das maschinelle Lernen künstlicher Intelligenzen, das Lernen aus historischen Daten, besser abschneiden kann oder wird als das humane. Die Antwort lautet: Nein! Denn die Fehlerquelle des menschlichen Lernens ist ja nicht allein die möglicherweise falsche Kombination oder Gewichtung bestimmter historischer Daten, sondern die zwangsläufige Vernachlässigung von Umgebungsbedingungen künftiger Ereignisse, die man niemandem vorwerfen kann, solange er oder sie nicht für sich in Anspruch nimmt, über seherische Fähigkeiten zu verfügen.

Maschinelles Lernen auf großer Datenbasis kann nur solange gegenüber menschlichen Prognosen realitätsnähere Zukunftsszenarien entwickeln, wie die jeweilige Zukunft einen endlichen Raum darstellt. Insofern wir beispielsweise über nicht von Menschen bevölkerte Werkshallen, Produktionsstätten oder Reinräume sprechen, dürfte es zulässig sein zu erwarten, dass eine künstliche Intelligenz auf der Basis eines definierten Soll-Outputs und eines gegebenen Geräteinputs eine optimale oder gar eine sich selbst optimierende Prozesslösung ableitet, und zwar in einem Grad, der jenseits der Fähigkeit humaner Planer liegt.

Bei offenen Räumen verhält es sich aber anders. Und Zukunft ist, von geschlossenen Systemen wie den genannten menschengemachten aber menschenentleerten Fabriken einmal abgesehen, grundsätzlich ein offener und damit unendlich großer Raum. Nur das Mäuerchen, auf dem der Projektor steht, die Gegenwart, ist vorhanden. Wir reden dann von einer unendlichen Vielzahl denkbarer und vielleicht nicht einmal denkbarer Zukünfte. Das Hilfsargument der Gaußschen Normalverteilung greift dort ins Leere, gleichgültig wie breit die Standardabweichung gewählt wird. Denn gleichgültig, wie viele historische Daten eine künstliche Intelligenz kombiniert und in den unendlichen Raum der Zukunft wirft, es bleiben eben historische Daten. Die Daten werden an keine Wand geworfen, weil es in diesem unendlichen Raum, jenseit des besagten Mäuerchens, keine Wand gibt.

Die Belastbarkeit historischer Daten als authentische Informationen über eine spezifische Zukunft ist vollkommen spekulativ; sie schöpft die „Raum“ künftiger Möglichkeiten nicht einmal ansatzweise aus. Die Zukunft ist erst spezifisch, nachdem sie Gegenwart geworden ist und egal wie „gut“ unsere künstliche Intelligenz lernt, sie lernt halt mit extrem hoher Wahrscheinlichkeit nicht das, was dereinst relevant sein wird.

Ich gebe zu, auch ich gehe davon aus, dass morgen die Sonne aufgehen wird. Insoweit ist das obige Statement scheinbar ein wenig radikal. Aber das ist es nicht. Denn ich spreche ja nicht über eine oder zwei globale Annahmen über die Beschaffenheit der Zukunft, sondern über extrem spezifische Zukunftsszenarien, Base Cases, Worst Cases und Best Cases zum Beispiel.